GROCK

Puisque votre site capitaine-jack.com est créé et hébergé sur Blogger, la création et l'intégration d'un plan de site (sitemap) doivent prendre en compte les particularités de cette plateforme. Blogger est limité en termes de personnalisation avancée, mais il est possible de créer une page HTML dédiée pour un plan de site optimisé pour le SEO, tout en respectant les contraintes de la plateforme. L'objectif est d'améliorer l'indexation par Google et de viser un meilleur classement. Voici un plan de site adapté à Blogger, avec des instructions spécifiques pour l'intégration et des conseils SEO.

1. Structure du plan de site pour capitaine-jack.com (sur Blogger)

Un plan de site HTML sur une page dédiée doit être simple, clair et inclure les pages statiques, articles, et catégories (étiquettes) de votre blog. Blogger utilise principalement des pages statiques pour ce type de contenu et génère automatiquement un sitemap XML pour Google. Voici une structure adaptée à un blog sur Blogger, en supposant que capitaine-jack.com est un blog lié à une thématique maritime, d’aventure, ou de récits (par exemple, navigation, voyages, conseils maritimes).

Plan de site HTML (à intégrer dans une page statique Blogger)

html

<!DOCTYPE html>

<html>

<head>

<meta charset="UTF-8">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<meta name="description" content="Plan du site de Capitaine Jack - Explorez tous les articles, pages et catégories du blog capitaine-jack.com.">

<meta name="robots" content="index, follow">

<title>Plan du site - Capitaine Jack</title>

<style>

body { font-family: Arial, sans-serif; margin: 20px; padding: 0; }

h1 { text-align: center; color: #003087; }

.sitemap { max-width: 800px; margin: 0 auto; }

.sitemap ul { list-style-type: none; padding-left: 20px; }

.sitemap li { margin: 10px 0; }

.sitemap a { text-decoration: none; color: #0055a4; }

.sitemap a:hover { text-decoration: underline; }

</style>

</head>

<body>

<h1>Plan du site - Capitaine Jack</h1>

<div class="sitemap">

<ul>

<li><a href="

https://www.capitaine-jack.com">Accueil</a></li>

<li>

<a href="

https://www.capitaine-jack.com/p/a-propos.html">À propos</a>

</li>

<li>

<a href="

https://www.capitaine-jack.com/p/nos-services.html">Nos services</a>

<ul>

<li><a href="

https://www.capitaine-jack.com/search/label/Navigation">Conseils de navigation</a></li>

<li><a href="

https://www.capitaine-jack.com/search/label/Destinations">Destinations maritimes</a></li>

<li><a href="

https://www.capitaine-jack.com/search/label/Équipement">Équipement maritime</a></li>

</ul>

</li>

<li>

<a href="

https://www.capitaine-jack.com/p/blog.html">Blog</a>

<ul>

<li><a href="

https://www.capitaine-jack.com/search/label/Conseils">Tous les conseils</a></li>

<li><a href="

https://www.capitaine-jack.com/search/label/Aventures">Récits d'aventures</a></li>

</ul>

</li>

<li><a href="

https://www.capitaine-jack.com/p/contact.html">Contact</a></li>

<li><a href="

https://www.capitaine-jack.com/p/mentions-legales.html">Mentions légales</a></li>

<li><a href="

https://www.capitaine-jack.com/p/politique-de-confidentialite.html">Politique de confidentialité</a></li>

</ul>

</div>

</body>

</html>

Explications de la structure

- Accueil : Pointe vers la page principale de votre blog (capitaine-jack.com).

- Pages statiques : Blogger permet de créer des pages comme "À propos", "Contact", ou "Mentions légales" via l’onglet "Pages". Ces pages sont listées ici.

- Catégories (étiquettes) : Les étiquettes Blogger (ex. : "Navigation", "Destinations") sont accessibles via des URLs comme /search/label/NomÉtiquette. Elles regroupent vos articles par thème.

- Blog : Une section pour les articles, organisée par étiquettes principales pour faciliter la navigation.

- Liens SEO : Les ancres des liens sont descriptives (ex. : "Conseils de navigation" au lieu de "Voir plus") pour optimiser le référencement.

2. Étapes pour intégrer le plan de site sur Blogger

Blogger ne permet pas d’uploader des fichiers HTML directement, mais vous pouvez créer une page statique pour afficher le plan de site. Voici comment procéder :

- Accédez à votre tableau de bord Blogger :

- Connectez-vous à Blogger (blogger.com) et sélectionnez votre blog capitaine-jack.com.

- Créez une nouvelle page statique :

- Dans le menu de gauche, cliquez sur Pages > Nouvelle page.

- Donnez un titre à la page, par exemple : Plan du site.

- Passez en mode HTML (dans l’éditeur de page, cliquez sur l’icône "< >" ou sélectionnez "HTML" au lieu de "Composer").

- Collez le code du plan de site :

- Copiez le code HTML fourni ci-dessus.

- Collez-le dans l’éditeur HTML de la page statique.

- Remplacez les URLs et les étiquettes par celles de votre blog (voir ci-dessous pour personnaliser).

- Personnalisez les URLs et étiquettes :

- Vérifiez l’URL de votre blog. Si vous utilisez un domaine personnalisé (capitaine-jack.com), assurez-vous que toutes les URLs dans le plan de site commencent par https://www.capitaine-jack.com.

- Remplacez les étiquettes (Navigation, Destinations, etc.) par les étiquettes réelles de votre blog. Pour les trouver :

- Ajoutez vos pages statiques existantes (ex. : /p/a-propos.html, /p/contact.html).

- Publiez la page :

- Ajoutez un lien dans la navigation :

- Allez dans Mise en page > Modifiez le gadget de menu ou du footer.

- Ajoutez un lien vers la page du plan de site (ex. : <a href="/p/plan-du-site.html">Plan du site</a>).

- Alternative : Ajoutez le lien dans un gadget "Liste de liens" ou dans le footer via Thème > Personnaliser > Modifier le HTML.

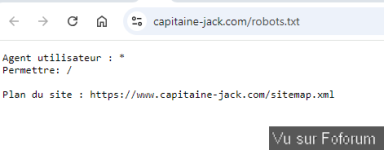

3. Sitemap XML pour Google (automatique sur Blogger)

Blogger génère automatiquement un sitemap XML pour votre blog, ce qui simplifie l’indexation par Google. Voici ce que vous devez savoir :

- Localisation du sitemap XML :

- Soumettez le sitemap à Google :

- Connectez-vous à Google Search Console (search.google.com).

- Sélectionnez votre propriété (capitaine-jack.com).

- Allez dans Sitemaps > Ajoutez l’URL : atom.xml?redirect=false&start-index=1&max-results=500.

- Validez pour que Google commence à explorer votre sitemap.

- Limitation :

- Le sitemap XML de Blogger inclut uniquement les articles (pas les pages statiques). Pour inclure les pages statiques, vous devez vous fier au plan de site HTML et aux liens internes.

4. Conseils SEO pour Blogger et Google

Pour maximiser vos chances d’être premier sur Google avec un blog Blogger, suivez ces recommandations :

- Optimisez chaque page et article :

- Titres : Utilisez des titres accrocheurs avec des mots-clés (ex. : "Meilleurs conseils de navigation maritime avec Capitaine Jack").

- Descriptions : Ajoutez une description SEO pour chaque article via Paramètres de l’article > Description de la recherche.

- Étiquettes : Utilisez des étiquettes pertinentes et cohérentes (ex. : "navigation", "bateaux", "voyages maritimes").

- Améliorez la vitesse du site :

- Choisissez un thème Blogger responsive et léger (ex. : thèmes comme "Contempo" ou "Emporio").

- Compressez les images avant de les uploader (utilisez TinyPNG ou Compressor.io).

- Testez la vitesse avec Google PageSpeed Insights.

- Contenu régulier et de qualité :

- Publiez des articles optimisés pour des mots-clés longue traîne (ex. : "comment naviguer en voilier pour débutants").

- Utilisez des sous-titres (H2, H3) et des images avec des balises alt (ex. : <img src="voilier.jpg" alt="Voilier en mer avec Capitaine Jack">).

- Maillage interne :

- Le plan de site HTML crée des liens vers vos pages statiques et étiquettes, ce qui aide Google à explorer votre blog.

- Dans vos articles, ajoutez des liens vers d’autres articles ou pages statiques (ex. : "Découvrez nos conseils de navigation").

- Backlinks et promotion :

- Partagez vos articles sur les réseaux sociaux (ex. : X, Instagram) pour générer du trafic.

- Collaborez avec d’autres blogs maritimes pour obtenir des liens entrants.

- Suivez vos performances :

- Utilisez Google Search Console pour voir les mots-clés qui génèrent des impressions et optimisez vos articles en conséquence.

- Installez Google Analytics pour suivre le trafic (ajoutez le code via Thème > Modifier le HTML).

5. Actions immédiates à entreprendre

- Vérifiez vos pages et étiquettes actuelles :

- Dans Blogger, listez toutes vos pages statiques (onglet "Pages") et étiquettes (onglet "Articles").

- Mettez à jour le code HTML du plan de site avec vos URLs exactes.

- Créez la page du plan de site :

- Suivez les étapes ci-dessus pour publier la page statique /p/plan-du-site.html.

- Soumettez le sitemap XML :

- Ajoutez atom.xml?redirect=false&start-index=1&max-results=500 à Google Search Console.

- Optimisez vos articles existants :

- Ajoutez des descriptions SEO et des mots-clés à vos articles les plus populaires.

- Vérifiez que chaque article a des liens internes vers d’autres pages ou étiquettes.

6. Personnalisation pour capitaine-jack.com

Si vous pouvez partager des détails spécifiques sur votre blog (par exemple, les étiquettes que vous utilisez, les types d’articles, ou vos mots-clés cibles), je peux affiner le plan de site et les recommandations SEO. Par ailleurs, si vous souhaitez que j’analyse votre blog via une recherche web ou X pour identifier des opportunités (ex. : mots-clés concurrents, structure actuelle), faites-le-moi savoir.

Ce plan de site HTML, combiné à l’utilisation du sitemap XML automatique de Blogger et à une stratégie SEO adaptée, devrait améliorer l’indexation de capitaine-jack.com et augmenter vos chances de grimper dans les résultats de Google. Voulez-vous que je développe un aspect spécifique (ex. : optimiser un article, créer une liste d’étiquettes, ou proposer un visuel pour la page du plan de site) ?